KI im Software-Outsourcing: Vorteile und rechtliche Bedenken

Mai 27, 2025

Categories: Fachkenntnisse, Technologien

In den letzten zwei bis drei Jahren haben sich Agenten der künstlichen Intelligenz (KI) immer stärker in den Softwareentwicklungsprozess integriert. Laut Statista nutzen drei von vier Entwicklern, also etwa 75 %, GitHub Copilot, OpenAI Codex, ChatGPT und andere generative KI bei ihrer täglichen Arbeit.

Doch auch wenn KI bei der Steuerung von Softwareentwicklungsaufgaben vielversprechend ist, schafft sie eine Welle der Rechtsunsicherheit.

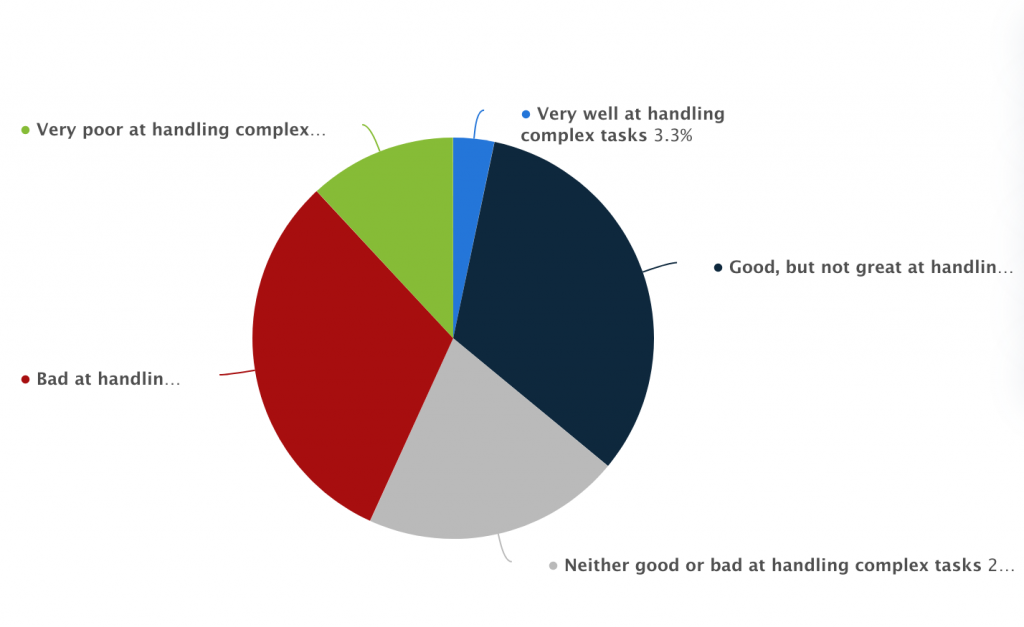

Fähigkeit der künstlichen Intelligenz zur Bewältigung komplexer Aufgaben, Statista

Wer ist Eigentümer des von einer KI geschriebenen Codes? Was passiert, wenn der von der KI geschriebene Code das geistige Eigentum eines anderen verletzt? Und welche Risiken bestehen für den Datenschutz, wenn kommerzielle Daten durch KI-Modelle verarbeitet werden?

Um all diese brennenden Fragen zu beantworten, erklären wir, wie die KI-Entwicklung aus rechtlicher Sicht betrachtet wird, insbesondere in Outsourcing-Fällen, und gehen auf alle Überlegungen ein, die Unternehmen berücksichtigen sollten, bevor sie diese Tools in ihre Arbeitsabläufe integrieren.

Was ist KI in der kundenspezifischen Softwareentwicklung?

Der Markt für KI-Technologien ist riesig und wird sich im Jahr 2025 auf rund 244 Milliarden US-Dollar belaufen. Allgemein wird KI in maschinelles Lernen und Deep Learning unterteilt, sowie weiter in natürliche Sprachverarbeitung, Computer Vision und mehr.

In der Softwareentwicklung bezieht sich der Begriff „KI-Tools“ auf intelligente Systeme, die Teile des Programmierprozesses unterstützen oder automatisieren können. Sie können Codezeilen vorschlagen, Funktionen vervollständigen und je nach Kontext oder Eingabeaufforderungen des Entwicklers sogar ganze Module generieren.

Gerade bei ausgelagerten Projekten – bei denen Geschwindigkeit ebenso wichtig ist wie Qualität – werden KI-Technologien schnell zu unverzichtbaren Bestandteilen der Entwicklungsumgebungen.

Sie steigern die Produktivität, indem sie sich um redundante Aufgaben kümmern, verringern den Zeitaufwand für Boilerplate-Code und helfen Entwicklern, die mit unbekannten Frameworks oder Sprachen arbeiten.

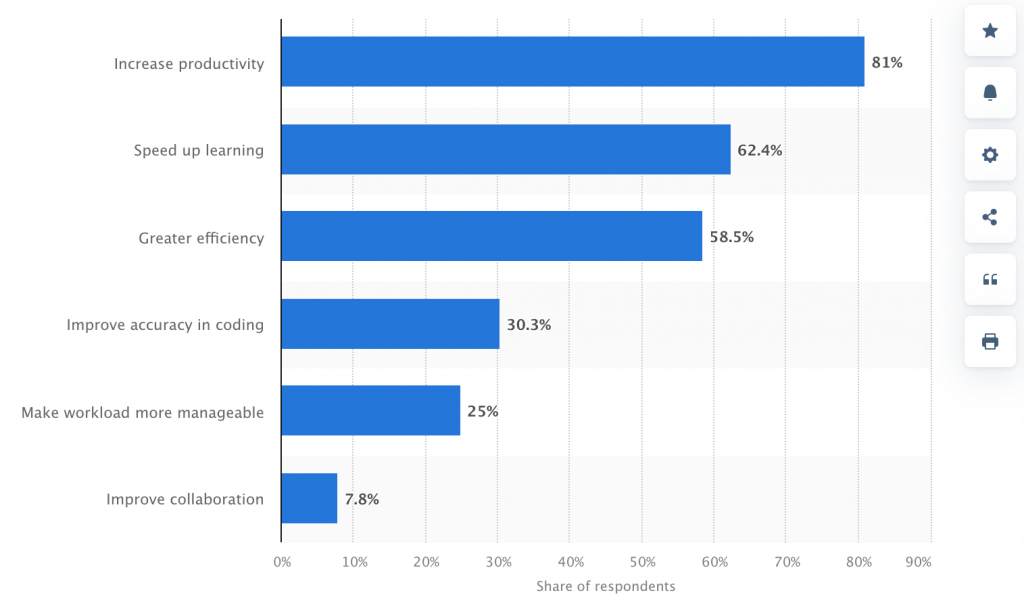

Vorteile der Nutzung künstlicher Intelligenz, Statista

Wie KI-Tools in Outsourcing-Projekte integriert werden können

Künstliche Intelligenz ist im Jahr 2025 zur gefragten Fähigkeit in nahezu allen technischen Berufen geworden.

Während Barkeeper oder Klempner vielleicht keine KI-Expertise benötigen, ist es für Softwareentwickler unverzichtbar, sich mit KI auszukennen – insbesondere im Kontext der ausgelagerten Softwareentwicklung. KI-Tools lassen sich in vielerlei Hinsicht einsetzen:

- Code-Generierung: GitHub Copilot und andere KI-Tools unterstützen ausgelagerte Entwickler, indem sie Vorschläge machen oder Funktionen automatisch vervollständigen.

- Fehlererkennung: Anstatt auf menschliche Verifizierung beim Softwaretesten zu warten, kann KI Fehler oder schädlichen Code markieren, sodass Probleme frühzeitig behoben werden können.

- Testgenerierung: KI kann selbstständig Testfälle aus dem Code erstellen, was die Tests schneller und gründlicher macht.

- Dokumentation: KI kann Kommentare einfügen und Dokumentationen erstellen, die erklären, was der Code macht.

- Mehrsprachige Unterstützung: Muss ein Projekt in eine andere Programmiersprache übertragen werden, kann KI beim Übersetzen oder Neuschreiben helfen und so den Bedarf an Spezialwissen verringern.

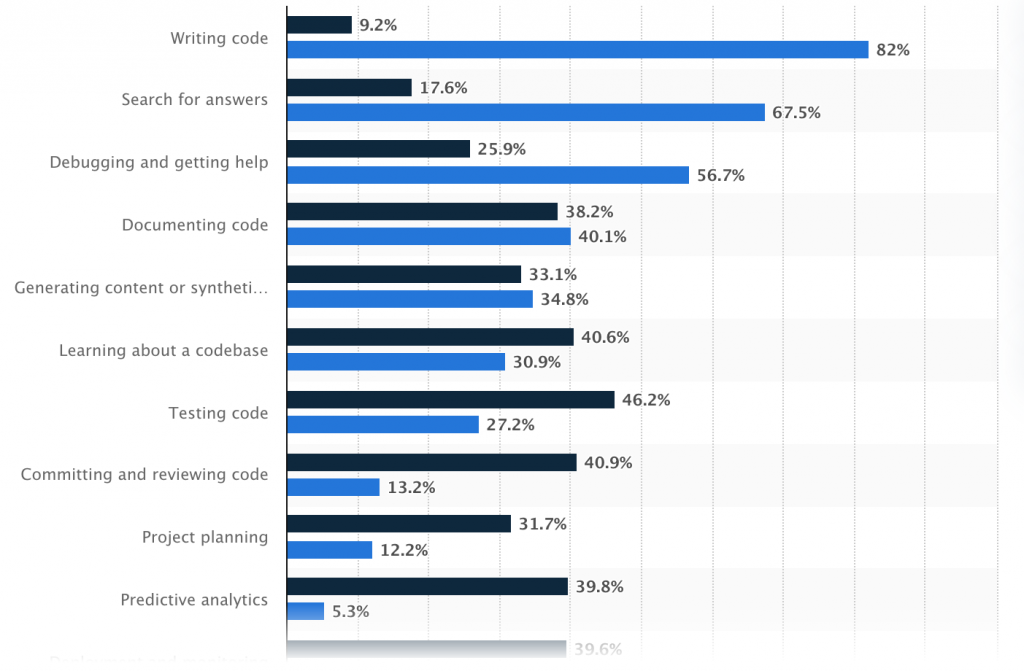

Beliebteste Einsatzbereiche von KI in der Entwicklung, Statista

Rechtliche Auswirkungen beim Einsatz von KI in der kundenspezifischen Softwareentwicklung

KI-Tools sind besonders in der ausgelagerten Softwareentwicklung äußerst hilfreich – werfen aber auch rechtliche Fragen auf, insbesondere in Bezug auf Eigentum, Datenschutz und Verantwortung.

Fragen des geistigen Eigentums (IP)

Wenn Entwickler KI-Tools wie GitHub Copilot, ChatGPT oder andere Code-Assistenten nutzen, stellt sich schnell die Frage: Wer besitzt eigentlich den resultierenden Code? Dies ist derzeit eine der komplexesten juristischen Fragen.

Es gibt bislang keine globale Regelung. Generell gehört KI nichts, und der Entwickler gilt als „Autor“. Doch es gibt Ausnahmen.

KI-Tools lernen aus riesigen Mengen existierenden Codes aus dem Internet. Dadurch kann es vorkommen, dass sie sehr ähnlichen oder gar identischen Code erzeugen – oft aus Open-Source-Projekten.

Wenn dieser Code zu nah am Original ist und unter einer restriktiven Open-Source-Lizenz steht, kann das zu rechtlichen Problemen führen, besonders wenn Lizenzbedingungen unbeachtet bleiben.

Outsourcing macht das noch komplexer. Wird KI im ausgelagerten Team verwendet, sollten Verträge besonders klar regeln:

- Wer besitzt den finalen Code?

- Was passiert, wenn KI versehentlich lizenzierten Code wiederverwendet?

- Darf das Outsourcing-Team überhaupt KI einsetzen?

Um vollständig rechtssicher zu bleiben:

- Verträge müssen klar regeln, wer den Code besitzt.

- Code muss auf Lizenzverletzungen geprüft werden.

- Lokal laufende Tools bevorzugen oder den Zugriff der KI einschränken, um Datenschutzrisiken zu vermeiden.

Datensicherheit und Datenschutz

Ein weiteres zentrales Thema beim Einsatz von KI-Tools – besonders im Outsourcing – ist der Datenschutz. Was ist also das Risiko?

Die meisten KI-Tools wie ChatGPT, Copilot und andere laufen in der Cloud. Informationen, die Entwickler eingeben, könnten also an externe Server übertragen werden.

Wer dabei vertrauliche Daten, Login-Daten oder proprietären Code eingibt, riskiert, dass diese Daten gespeichert, weiterverwendet oder offengelegt werden. Besonders kritisch ist das bei:

- Vertraulichen Unternehmensdaten

- Kundendaten oder personenbezogenen Informationen

- Branchen mit hohen regulatorischen Anforderungen (Gesundheit, Finanzen)

Wichtige gesetzliche Regelungen:

- GDPR (Europa): Die GDPR schützt personenbezogene Daten. Wer Daten von EU-Bürgern erhebt, muss erklären, was gesammelt wird, warum und eine Einwilligung einholen. Personen haben das Recht auf Auskunft, Korrektur und Löschung.

- HIPAA (USA, Gesundheitswesen): HIPAA regelt medizinische Daten. Patientendaten dürfen nicht einfach in Online-KI-Tools eingegeben werden. Auch Partner wie Outsourcing-Teams müssen dieselben Regeln einhalten und Vereinbarungen unterzeichnen.

- CCPA (Kalifornien): Das CCPA gibt Einwohnern Kaliforniens Kontrolle über ihre Daten. Unternehmen müssen offenlegen, welche Daten gesammelt werden, warum, und auf Anfrage Daten löschen oder nicht verkaufen.

Wie man Daten schützt:

- Keine sensiblen Informationen in öffentliche KI-Tools eingeben.

- Für vertrauliche Projekte auf lokal laufende KI-Tools setzen.

- Verträge mit Outsourcing-Partnern sorgfältig prüfen.

Verantwortung und Haftung

KI-Tools übernehmen viele Aufgaben, aber keine Verantwortung. Die Verantwortung liegt immer bei den Menschen – also Entwicklern, Teams und Auftraggebern.

Wenn der Code fehlerhaft ist oder Schaden verursacht, ist nicht die KI schuld, sondern die Menschen, die sie eingesetzt haben. Fehlende Zuständigkeit kann zu gravierenden Problemen führen.

Um das zu vermeiden:

- KI-generierten Code immer prüfen. Es ist nur ein Ausgangspunkt.

- Verantwortung klar zuweisen – intern oder extern.

- Verträge sollten regeln:

- Ob KI-Tools erlaubt sind

- Wer die Ergebnisse prüft

- Wer haftet, wenn Fehler durch KI entstehen

- Ob KI-Tools erlaubt sind

- Einsatz von KI dokumentieren, insbesondere bei wichtigen Codebeiträgen.

Fallstudien und Praxisbeispiele

KI in der Softwareentwicklung ist längst Realität – besonders in kleineren Unternehmen mit schlanken Teams.

Nabla (Healthtech-Startup aus Frankreich)

Nabla nutzt GPT-3 (via OpenAI), um Ärzten bei der Erstellung von Notizen zu helfen.

- KI hört Gespräche zwischen Arzt und Patient mit und erstellt strukturierte Notizen.

- Verwaltungsaufwand für Ärzte sinkt erheblich.

Datenschutzmaßnahmen:

- Nabla verzichtet auf OpenAI-API wegen Datenschutzbedenken und DSGVO.

- Stattdessen setzen sie lokal gehostete Open-Source-Modelle wie GPT-J ein.

Lektion: In sensiblen Branchen sind selbstgehostete KI-Modelle oft sicherer als Cloud-APIs.

Replit und Ghostwriter

Replit hat mit Ghostwriter seinen eigenen KI-Assistenten entwickelt.

- Ghostwriter hilft Nutzern beim Coden im Browser.

- Wird besonders im Bildungsbereich und bei Startups eingesetzt.

Herausforderung:

- Balance zwischen Benutzerfreundlichkeit und Lizenzkonformität.

- Nutzer werden ermutigt, den generierten Code zu prüfen.

Lektion: Auch bei hauseigenen KI-Tools ist menschliche Kontrolle unerlässlich.

Amazon – Interne KI-Codetools

Amazon verwendet eigene KI-Tools, um Entwickler zu unterstützen.

- Helfen beim Schreiben und Prüfen von Code in verschiedenen Teams.

- Ziel ist höhere Produktivität.

Warum keine externen Tools?

- Strenge interne Richtlinien für IP und Datenschutz.

- Interne Lösungen verringern rechtliche Risiken.

Lektion: Große Unternehmen vermeiden Drittanbieter-KI wegen Datenschutz- und IP-Risiken.

Sichere Nutzung von KI-Tools in Outsourcing-Projekten: Allgemeine Empfehlungen

Der Einsatz von KI-Tools in ausgelagerten Entwicklungsprojekten kann die Auslieferung beschleunigen, Kosten senken und die Produktivität beim Coden erhöhen. Damit dies jedoch sicher geschieht, müssen Unternehmen von Anfang an die richtigen Prozesse und Schutzmaßnahmen etablieren.

Zunächst ist es entscheidend, die Erwartungen hinsichtlich der KI-Nutzung vertraglich klar mit den Outsourcing-Partnern zu regeln. Die Vereinbarungen sollten eindeutig festlegen, ob und unter welchen Bedingungen KI-Tools eingesetzt werden dürfen – und wer für die Überprüfung sowie Validierung von KI-generiertem Code verantwortlich ist.

Diese Verträge sollten auch starke Klauseln zum geistigen Eigentum enthalten, in denen geregelt ist, wem der finale Code gehört und was geschieht, falls durch KI versehentlich Open-Source- oder anderweitig lizenzierter Drittanbieter-Code eingebracht wird.

Datenschutz ist ein weiterer kritischer Punkt. Wenn Entwickler KI-Tools verwenden, die Daten in die Cloud übertragen, dürfen keinerlei sensible oder proprietäre Informationen eingegeben werden – es sei denn, das Tool erfüllt die Anforderungen der DSGVO, HIPAA oder CCPA.

In stark regulierten Branchen ist es immer sicherer, selbstgehostete KI-Modelle oder Versionen zu verwenden, die in einer kontrollierten Umgebung laufen, um das Risiko ungewollter Datenfreigabe zu minimieren.

Zur Vermeidung rechtlicher und qualitativer Probleme sollte zudem eine menschliche Kontrolle in allen Entwicklungsphasen sichergestellt werden. KI-Tools geben nützliche Hinweise, doch sie verstehen weder den Geschäftskontext noch rechtliche Anforderungen.

Entwickler müssen deshalb weiterhin alle Codes testen, prüfen und erneut analysieren, bevor sie produktiv gehen. Die Einrichtung eines Code-Review-Workflows, bei dem erfahrene Entwickler KI-Ergebnisse gegenprüfen, garantiert Sicherheit und Verantwortlichkeit.

Ebenso sinnvoll ist es, die Nutzung von KI-Tools im Entwicklungsprozess zu dokumentieren. Eine nachvollziehbare Aufzeichnung hilft dabei, spätere Fehlerquellen oder rechtliche Probleme zurückzuverfolgen und signalisiert gegenüber Aufsichtsbehörden verantwortungsbewusstes Handeln.

FAQ

F: Wem gehört KI-generierter Code?

Dem Unternehmen – sofern im Vertrag geregelt. Wird lizenzierter Open-Source-Code ungewollt reproduziert, kann es Probleme geben. Verträge und manuelle Prüfungen sind entscheidend.

F: Ist KI-generierter Code sofort nutzbar?

Nicht unbedingt. KI kann geschützten Code reproduzieren. Vorschläge sind nur Ausgangspunkte. Entwickler müssen prüfen und anpassen.

F: Darf man vertrauliche Daten in ChatGPT eingeben?

Nur wenn es sich um eine sichere, private Version handelt. Öffentlich verfügbare Tools bergen Datenschutzrisiken.

F: Welche Datenschutzgesetze gelten?

Je nach Region: DSGVO (Europa), HIPAA (USA), CCPA (Kalifornien). KI-Tools müssen diesen entsprechen, wenn sie personenbezogene Daten verarbeiten.

F: Wer haftet bei Fehlern durch KI-Code?

Die Entwickler – nicht die KI. Der Code muss manuell geprüft werden. KI beschleunigt nur, übernimmt aber keine Verantwortung.

F: Wie nutzt man KI-Tools sicher im Outsourcing?

Verträge müssen alles regeln: Nutzung, Eigentum, Prüfung. Nur vertrauenswürdige Tools verwenden, keine sensiblen Daten eingeben, Entwickler schulen.

F: Nutzt SCAND KI zur Softwareentwicklung?

Ja, sofern der Kunde zustimmt. Bei lizenzierten Tools nutzen wir Microsoft Copilot in VSCode und Cursor IDE mit Modellen wie ChatGPT 4o, Claude Sonnet, DeepSeek und Qwen. Für private Setups setzen wir lokal gehostete KI-Assistenten wie Ollama, LM Studio und llama.cpp ein – alles auf gesicherten Rechnern.

F: Nutzt SCAND KI zum Testen von Software?

Ja, mit Genehmigung des Kunden. Wir verwenden ChatGPT 4o und Qwen Vision für automatisierte Tests sowie Playwright und Selenium für Browsertests. Bei Bedarf generieren wir automatisch Unit-Tests mit Copilot, Cursor oder lokalen Tools wie Llama, DeepSeek, Qwen und Starcoder.